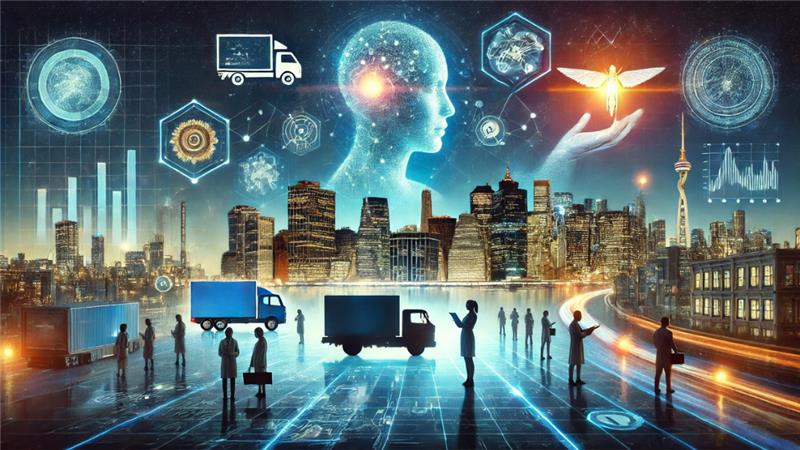

« L’émergence de l’intelligence artificielle générative a marqué un tournant majeur dans le paysage technologique, suscitant à la fois fascination et espoir. En quelques années, elle a révélé des potentialités extraordinaires, promettant de transformer des secteurs entiers, de l’automatisation des tâches créatives à la résolution de problèmes complexes. Cette montée en puissance a propulsé l’IA au centre des débats technologiques, économiques et éthiques.

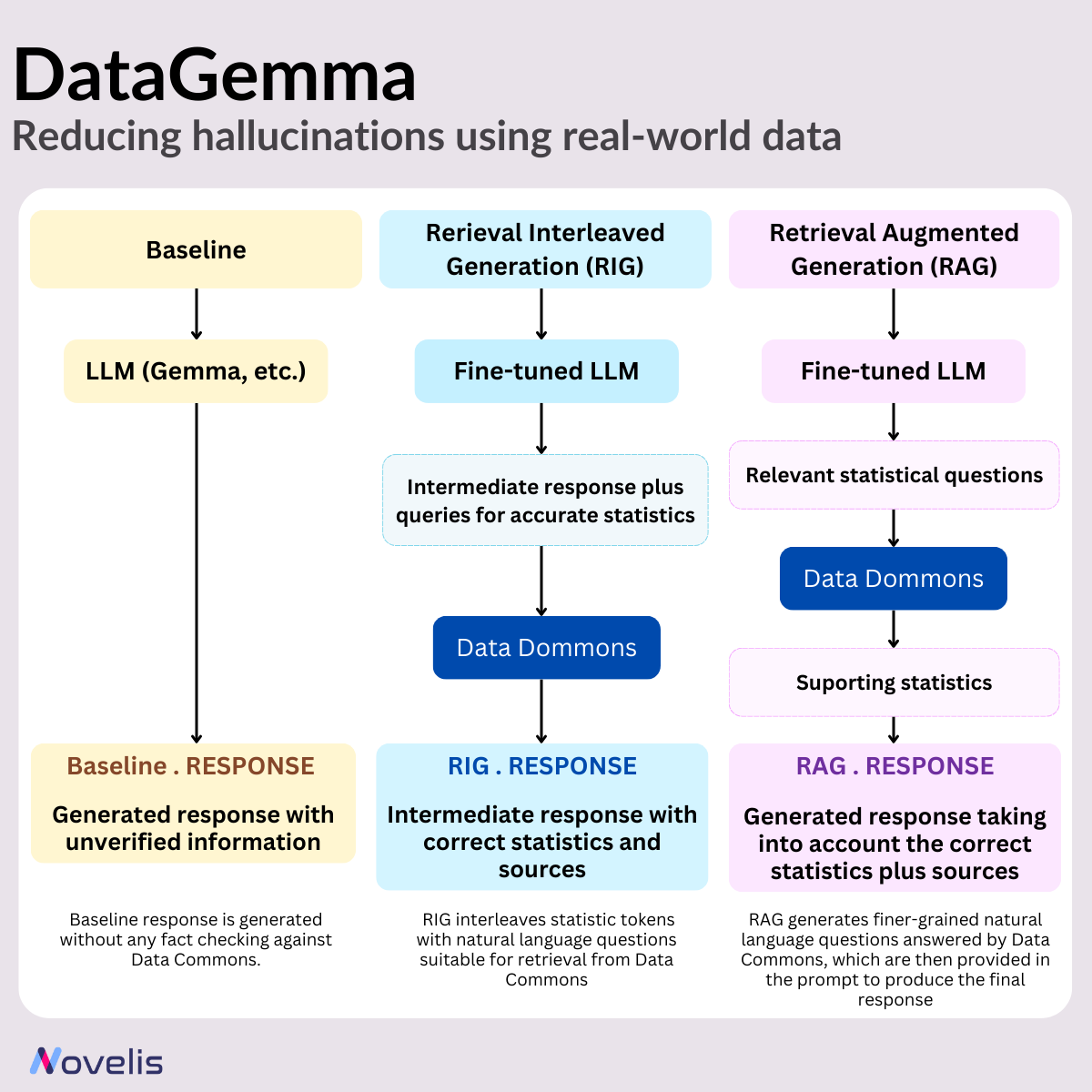

Cependant, l’IA générative n’échappe pas aux critiques. Certains remettent en question les coûts élevés de mise en place et d’entraînement des grands modèles, pointant du doigt les infrastructures massives et les ressources énergétiques nécessaires. D’autres soulignent le problème des hallucinations, ces moments où les modèles produisent des informations erronées ou incohérentes, impactant potentiellement la fiabilité des services offerts. Par ailleurs, certains la comparent à une « bulle » technologique, faisant écho aux spéculations passées autour des cryptomonnaies ou du métavers, affirmant que l’engouement actuel pour l’IA pourrait être éphémère et surévalué.

Ces interrogations sont légitimes et alimentent un débat essentiel sur l’avenir de l’IA. Toutefois, se limiter à ces critiques revient à ignorer les transformations profondes et les impacts concrets que l’intelligence artificielle est déjà en train d’engendrer dans de nombreux secteurs. »

Veuillez remplir le formulaire pour télécharger le document et en savoir plus

El Hassane Ettifour, notre Directeur de la Recherche et de l’Innovation, plonge dans ce sujet et partage ses réflexions dans cette vidéo exclusive.