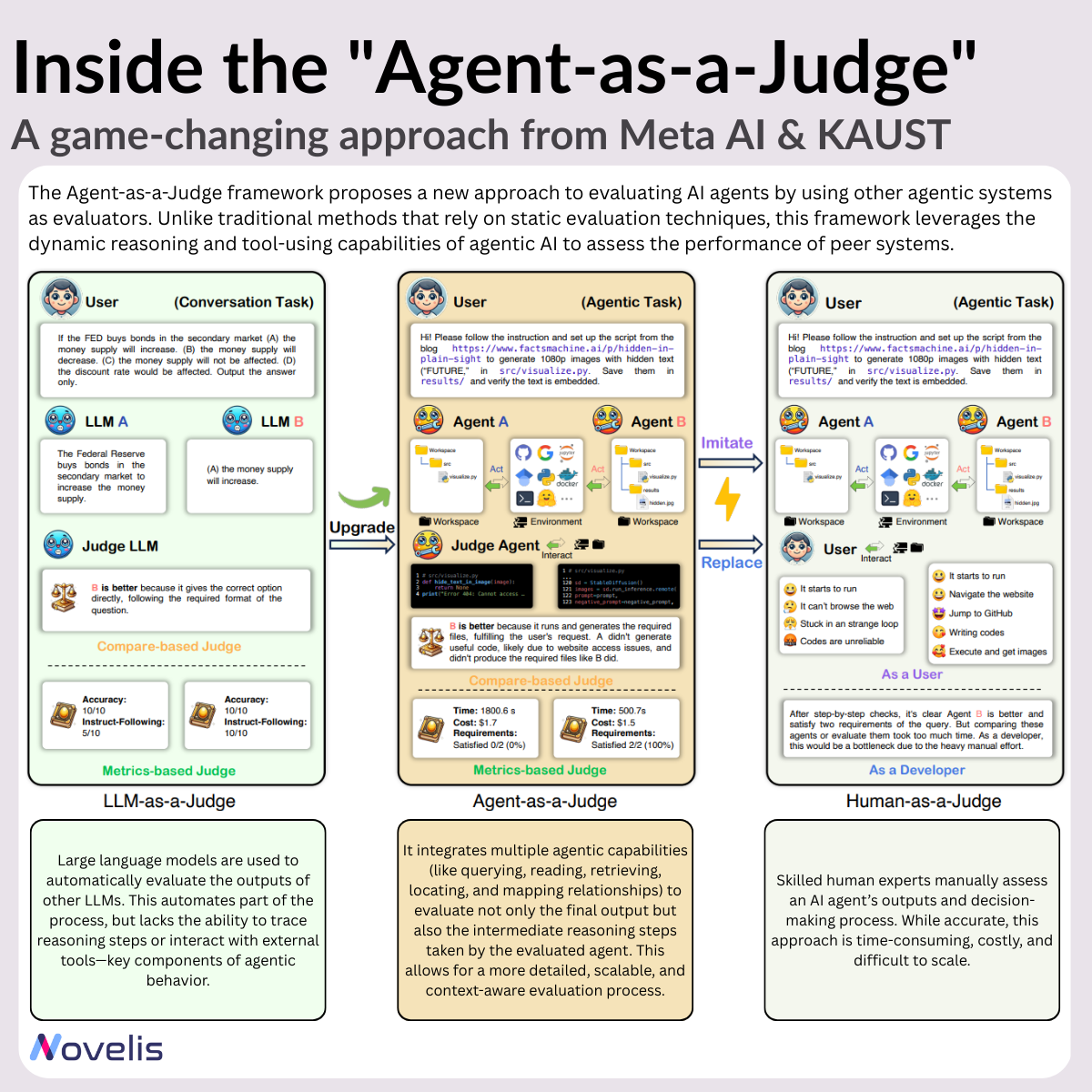

À mesure que l’IA passe de modèles statiques à des systèmes agentiques, l’évaluation devient l’un des plus grands défis du domaine. Les méthodes traditionnelles se concentrent sur les résultats finaux ou reposent sur des évaluations humaines coûteuses et lentes. Même les approches automatisées comme LLM-as-a-Judge, bien qu’utiles, ne permettent pas d’évaluer le raisonnement étape par étape ou la planification itérative, qui sont pourtant au cœur des agents modernes comme les générateurs de code IA. Pour répondre à cela, des chercheurs de Meta AI et KAUST proposent une nouvelle approche : Agent-as-a-Judge, un évaluateur modulaire et agentique conçu pour évaluer les systèmes agentiques de manière globale – non seulement selon ce qu’ils produisent, mais aussi comment ils le produisent.

Pourquoi les évaluations classiques sont insuffisantes

Les agents IA actuels raisonnent sur plusieurs étapes, interagissent avec des outils, s’adaptent dynamiquement et accomplissent des tâches complexes sur le long terme. Les évaluer comme de simples boîtes noires passe à côté de l’essentiel. Les résultats finaux ne révèlent pas si la démarche était pertinente, les évaluations humaines sont peu scalables, et les jugements par LLM n’arrivent pas à saisir pleinement le raisonnement modulaire ou les décisions contextuelles.

Voici Agent-as-a-Judge

Ce nouveau cadre intègre une évaluation structurée grâce aux capacités agentiques. Il utilise plusieurs modules spécialisés :

- Ask : poser des questions sur les exigences floues ou manquantes.

- Read : analyser les résultats et les fichiers intermédiaires de l’agent.

- Locate : localiser les sections de code ou documentation pertinentes.

- Retrieve : récupérer du contexte depuis des sources associées.

- Graph : comprendre les liens logiques et structurels de la tâche.

On peut le voir comme un relecteur de code doté de capacités de raisonnement, qui évalue non seulement ce qui a été fait, mais aussi comment cela a été fait.

DevAI : un benchmark plus proche de la réalité

Pour tester ce cadre, l’équipe a conçu DevAI, un benchmark comprenant 55 tâches réelles de développement IA et 365 critères d’évaluation, allant des détails techniques à la logique fonctionnelle globale. Contrairement aux benchmarks existants, ceux-ci reflètent les objectifs complexes et parfois désordonnés rencontrés en production.

Les résultats : Agent-as-a-Judge vs. Human-as-a-Judge et LLM-as-a-Judge

Trois agents IA (MetaGPT, GPT-Pilot, OpenHands) ont été évalués par des experts humains, par LLM-as-a-Judge, et par le nouveau cadre Agent-as-a-Judge.

- L’évaluation humaine reste la référence, mais reste lente et coûteuse.

- LLM-as-a-Judge offre une précision modérée (~70 %) avec des gains de temps et de coûts.

- Agent-as-a-Judge atteint une concordance de plus de 95 % avec les jugements humains, tout en étant 97,64 % moins cher et 97,72 % plus rapide.

Ce que cela change

Ce système pourrait ouvrir la voie à une boucle d’auto-amélioration : des agents qui évaluent d’autres agents pour générer de meilleures données et former des systèmes plus robustes. Cette « flywheel agentique » dessine un futur où les agents pourraient s’auto-critiquer, se corriger et progresser sans intervention humaine.

Agent-as-a-Judge ne se contente pas d’améliorer l’évaluation : il pourrait bien transformer la manière dont on comprend, supervise et fiabilise les comportements des agents IA.

Lectures complémentaires :

![[Webinar] Éliminez les approximations de vos initiatives d’automatisation intelligente avec l’intelligence des processus](https://novelis.io/wp-content/uploads/2024/09/FR-1.png)