L’ingénierie du contexte : la nouvelle frontière pour construire des systèmes d’IA fiables

11/09/2025

11 Sep , 2025 read

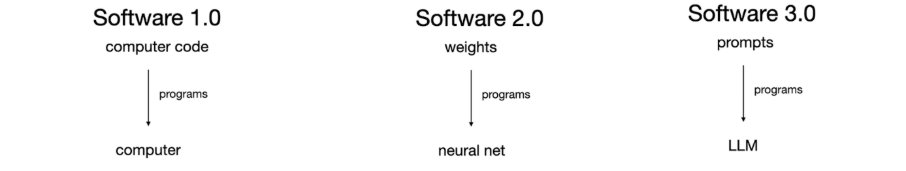

À mesure que les grands modèles de langage (LLMs) comme GPT, Claude et Gemini deviennent les piliers des applications d’IA, la question n’est plus de savoir si nous allons les utiliser, mais comment nous devons concevoir leur utilisation.

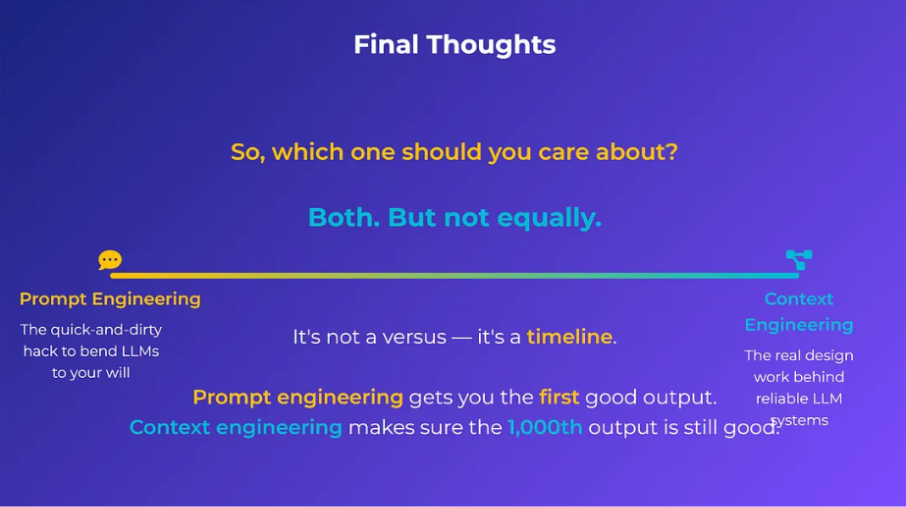

L’ingénierie des prompts, consistant à créer des instructions astucieuses pour obtenir des résultats souhaités, nous a permis d’aller loin. Pourtant, à mesure que les applications réelles deviennent plus complexes, cette approche révèle ses limites fondamentales.

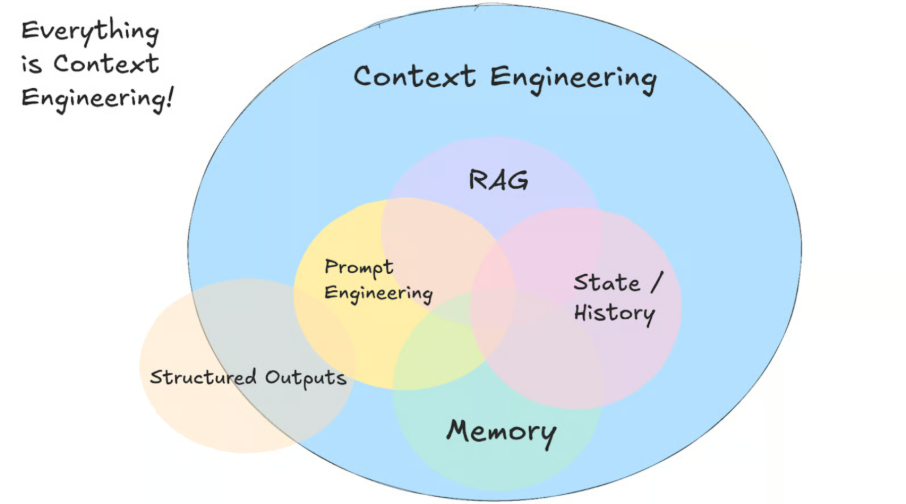

C’est là qu’intervient l’ingénierie du contexte : une discipline en pleine évolution, qui se concentre sur la conception d’environnements informationnels dynamiques et structurés. Ces environnements permettent aux LLMs de fonctionner de manière cohérente, fiable et à grande échelle.

Dans cet article, nous expliquons ce qu’est l’ingénierie du contexte, pourquoi elle est essentielle, en quoi elle diffère de l’ingénierie des prompts, les écueils fréquents, ainsi que les techniques et outils qui la soutiennent.

(Découvrez l’article précédent “Software 3.0 : Comment les modèles de langage transforment la programmation et les applications” https://novelis.io/research-lab/software-3-0-how-large-language-models-are-reshaping-programming-and-applications/)

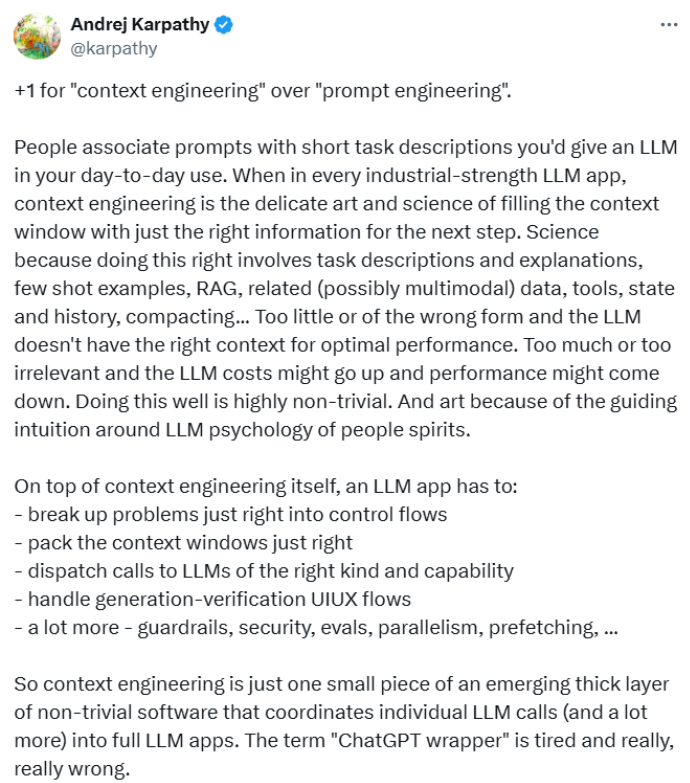

Alors que l’ingénierie des prompts consiste à rédiger des instructions statiques ou ponctuelles, l’ingénierie du contexte prend en compte la complexité des systèmes dynamiques qui gèrent la manière dont l’information circule dans la fenêtre de contexte du modèle — la mémoire de travail du LLM, où il « voit » et raisonne sur les données.

(Source: https://github.com/humanlayer/12-factor-agents/)

Par analogie, Andrej Karpathy explique dans une de ses conférences que le LLM est comme un processeur (CPU) et la fenêtre de contexte comme sa RAM : une mémoire de travail limitée et précieuse, qu’il faut organiser avec soin pour en tirer le maximum de performance. L’ingénierie du contexte consiste précisément à optimiser cette RAM afin de permettre des applications d’IA sophistiquées et multi-étapes.

De façon plus formelle, le contexte regroupe tout ce dont l’IA a besoin pour bien raisonner : notes, références, interactions passées, sorties d’outils externes, consignes de formatage, etc. Les humains gèrent naturellement ces éléments, mais pour une IA, il faut concevoir explicitement cet environnement informationnel.

Différences clés entre ingénierie du contexte et ingénierie des prompts

L’ingénierie des prompts consiste à savoir quoi dire, à formuler des instructions ou des questions pour que le modèle réponde correctement. Elle est efficace dans des scénarios simples de type chatbot.

L’ingénierie du contexte consiste à savoir comment gérer toutes les informations et instructions nécessaires à l’IA pour exécuter des tâches complexes dans des conditions variées. Elle orchestre plusieurs composants pour que l’IA applique la bonne connaissance au bon moment.

En résumé :

- L’ingénierie des prompts, c’est comme expliquer à quelqu’un quoi faire.

- L’ingénierie du contexte, c’est comme lui fournir les bons outils, les bonnes informations et l’environnement adapté pour qu’il réussisse.

Ce changement est crucial car les agents IA ne peuvent pas simplement « discuter jusqu’à trouver la bonne réponse ». Ils nécessitent un contexte complet et autonome, englobant tous les scénarios et ressources nécessaires, gérés de façon dynamique.

Pourquoi l’ingénierie du contexte est essentielle

- Fiabilité à grande échelle : sans gestion rigoureuse du contexte, les modèles oublient ou inventent des détails, ce qui peut poser des risques (incohérences, non-conformité, erreurs critiques).

- Gestion de la complexité : les applications réelles impliquent couches de connaissances, outils et historique utilisateur. Les prompts deviennent vite trop lourds et incohérents. L’ingénierie du contexte apporte structure et clarté.

- Dépassement des limites des prompts : un seul prompt ne suffit pas pour gérer mémoire, rôles multiples et intégration d’outils. L’ingénierie du contexte permet une mémoire modulaire, persistante et évolutive.

En clair : pour construire des agents IA capables de raisonnement complexe et d’interactions système, l’ingénierie du contexte est incontournable.

Les composants fondamentaux d’un agent IA

L’ingénierie du contexte coordonne six éléments clés :

- Modèle : le LLM de base (ex. GPT-4, Claude, Gemini).

- Outils : APIs et systèmes externes (ex. calendrier, recherche).

- Connaissance et mémoire : données pertinentes stockées, historique des sessions, apprentissages.

- Audio et parole : interfaces conversationnelles naturelles.

- Garde-fous : contrôles éthiques et de sécurité.

- Orchestration : déploiement, suivi et amélioration continue.

Modes d’échec fréquents

- Empoisonnement du contexte : informations erronées ou inventées intégrées dans le contexte.

- Distraction du contexte : surcharge d’historique qui empêche un raisonnement frais.

- Confusion du contexte : informations contradictoires ou hors sujet qui brouillent l’IA.

- Conflit de contexte : données incompatibles menant à des résultats instables.

Ces problèmes se résolvent par une conception et une curation minutieuses du contexte.

Techniques clés d’ingénierie du contexte

- Écriture du contexte : stocker notes intermédiaires, connaissances à long terme, préférences utilisateurs.

- Sélection du contexte : récupérer uniquement les infos pertinentes (ex. recherche sémantique, RAG).

- Compression du contexte : résumer et hiérarchiser l’historique pour rester dans les limites de tokens.

- Isolation du contexte : séparer les tâches via des architectures multi-agents pour éviter les interférences.

Outils et frameworks

Plateformes d’orchestration : intégration et supervision des différents modules.

Programmation déclarative (ex. DSPI) : définir quoi produire, pas comment demander.

Structures de contrôle (ex. LangGraph) : workflows basés sur graphes avec persistance d’état.

Bases vectorielles (ex. Pinecone, Weaviate, Chroma) : recherche sémantique dans de grands ensembles de données.

Génération structurée : garantir des sorties cohérentes et exploitables (JSON, XML).

Systèmes de mémoire avancés (ex. MEZero) : gestion intelligente de l’information (hiérarchies, expiration).

(Source: “Context Engineering vs Prompt Engineering” by Mehul Gupta)

Conclusion

L’ingénierie du contexte représente une évolution majeure dans la conception des systèmes d’IA. Elle déplace le focus de la simple rédaction d’instructions vers la création d’écosystèmes informationnels dynamiques.

Pour qui développe des applications ou agents IA avancés, maîtriser l’ingénierie du contexte est désormais indispensable. En surmontant les limites des prompts seuls et en s’appuyant sur des outils et architectures robustes, elle permet de révéler tout le potentiel des LLMs et de les transformer en partenaires fiables sur des tâches complexes et réelles.

Resources :

- The New Skill in AI is Not Prompting, It’s Context Engineering

- 12-Factor Agents – Principles for building reliable LLM applications

- Context Engineering for Agents

- A Survey of Context Engineering for Large Language Models