L’IA juridique : un couteau à double tranchant – gains d’efficacité vs risques d’hallucinations

23/09/2025

23 Sep , 2025 read

La montée en puissance rapide des grands modèles de langage (LLMs) place la profession juridique à un tournant décisif. D’un côté, ces outils promettent de simplifier la recherche complexe, d’accélérer la rédaction et même de transformer un langage législatif dense en formats structurés et exploitables. De l’autre, leurs limites bien documentées – notamment en matière de précision et de fiabilité – rendent leur rôle dans un domaine aussi sensible très contesté. Cette tension entre opportunité et risque est désormais au cœur du débat : les LLMs sont-ils prêts à devenir des collaborateurs de confiance pour les juristes, ou doivent-ils rester des instruments étroitement supervisés – utiles, mais jamais totalement autonomes ?

Deux études récentes illustrent parfaitement ce débat. Hallucination-Free? Assessing the Reliability of Leading AI Legal Research Tools propose une analyse critique des plateformes propriétaires de recherche juridique par IA, en évaluant systématiquement leurs forces et faiblesses. À l’inverse, From Text to Structure: Using Large Language Models to Support the Development of Legal Expert Systems explore une voie plus constructive, montrant comment les LLMs peuvent contribuer à convertir le texte législatif en systèmes transparents et fondés sur des règles, améliorant ainsi l’accessibilité et la précision. Ensemble, ces travaux soulignent la double nature des LLMs en droit : à la fois source d’inquiétude et moteur d’innovation.

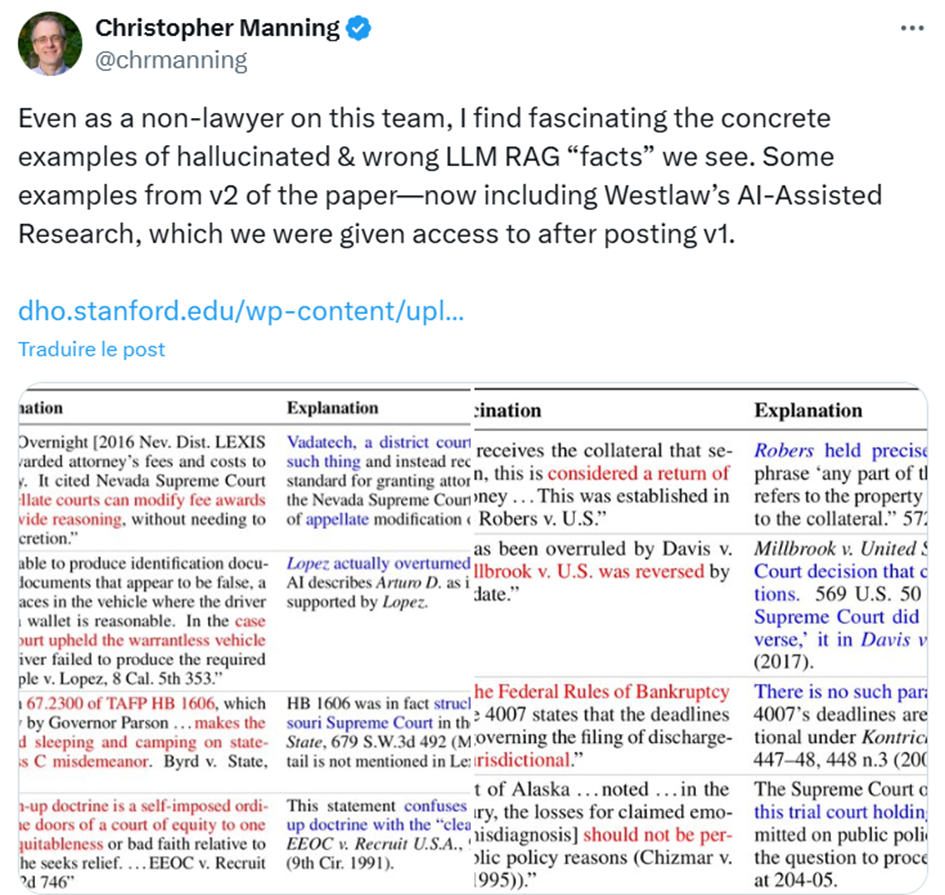

Lien : https://x.com/chrmanning/status/1796593594654130230

La promesse : les LLMs comme intelligence augmentée

Une vision optimiste considère ces modèles comme de puissants catalyseurs de « l’intelligence augmentée ». Ils pourraient lever un goulot d’étranglement majeur dans la construction de systèmes d’aide à la décision juridique – des outils essentiels pour élargir l’accès à la justice.

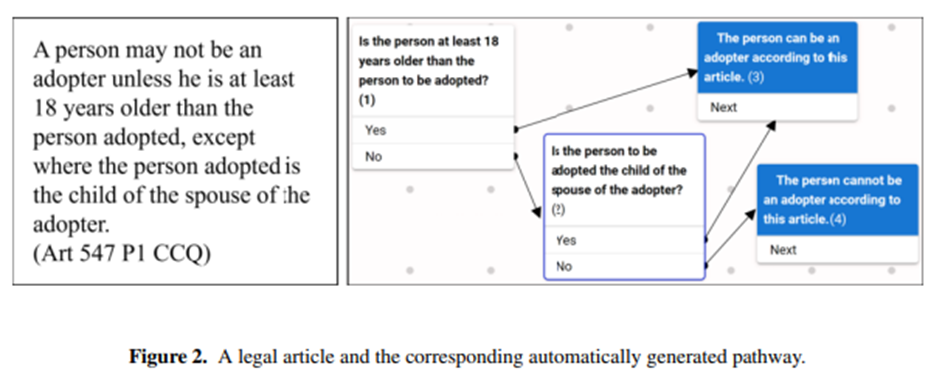

Fluidifier un processus clé

Traditionnellement, encoder un texte législatif complexe en une représentation structurée, fondée sur des règles – appelée pathways (enchaînements de critères et de conclusions) – est une tâche coûteuse et chronophage. Or, ces données structurées sont la base d’outils comme JusticeBot, qui aident les non-juristes à comprendre l’application de la loi. Dans une étude, des chercheurs ont utilisé GPT-4 pour automatiser l’extraction de pathways à partir de 40 articles du Code civil du Québec.

Des résultats encourageants

Les conclusions sont prometteuses et montrent le potentiel des LLMs comme assistants efficaces pour les experts juridiques :

- Haute précision et utilité : GPT-4 a atteint 92,5 % de précision textuelle. Plus encore, 90 % des pathways générés ont été jugés utiles pour les outils d’aide à la décision – 40 % directement exploitables, 50 % nécessitant seulement des ajustements mineurs.

- Comparaison avec les annotateurs humains : dans des évaluations en aveugle, 60 % des pathways produits par le LLM ont été jugés équivalents ou supérieurs à ceux créés manuellement. Pour les articles plus simples, ce chiffre est monté à 77,8 %. Certains résultats ont même permis aux experts humains de détecter des erreurs logiques dans leur propre travail.

- Faible taux d’hallucination : dans 87,5 % des cas, GPT-4 est resté fidèle au texte source, sans inventer de critères ni de conclusions.

Cette approche positionne les LLMs non pas comme des remplaçants, mais comme des collaborateurs, capables d’assurer la rédaction initiale fastidieuse afin que les experts se concentrent sur la vérification et l’affinage. L’objectif : accélérer la création de systèmes d’aide à la décision et, ce faisant, élargir l’accès à la justice.

Le risque : la réalité des hallucinations persistantes

À l’opposé, une deuxième étude – évaluant la fiabilité des principaux outils de recherche juridique par IA – adopte une posture plus prudente. Elle montre que, malgré les promesses commerciales, ces solutions souffrent encore d’hallucinations fréquentes et problématiques, imposant une forte charge de supervision aux professionnels du droit.

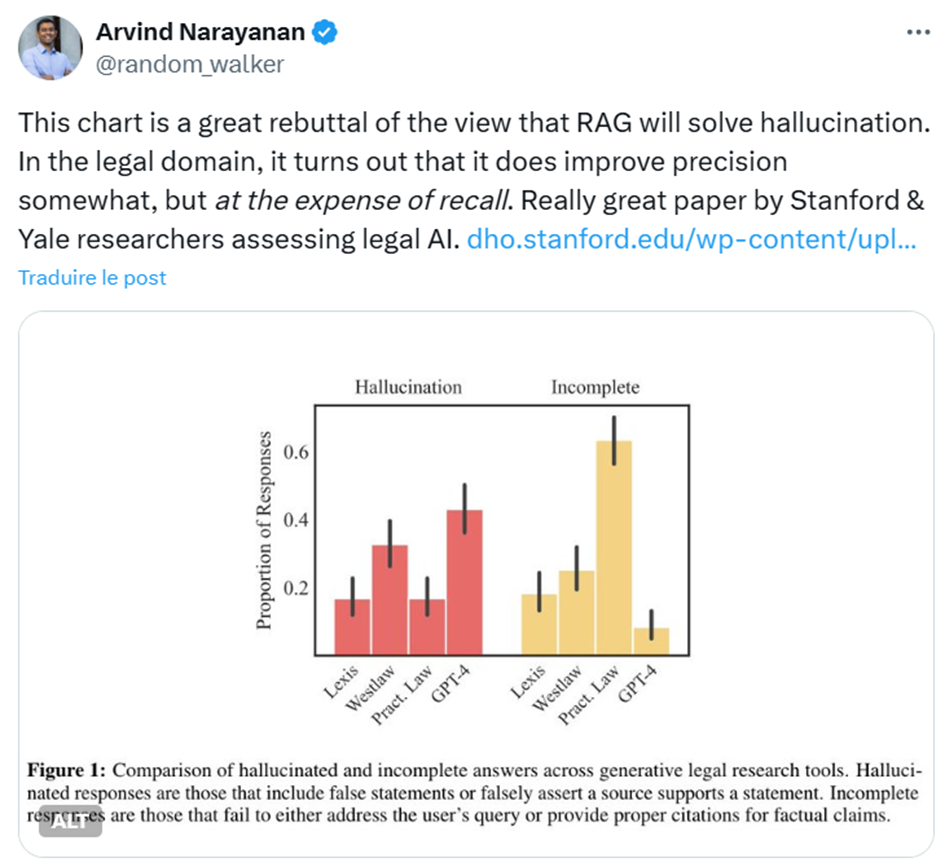

Lien : https://x.com/random_walker/status/1796557544241901712

Des promesses exagérées et des hallucinations tenaces

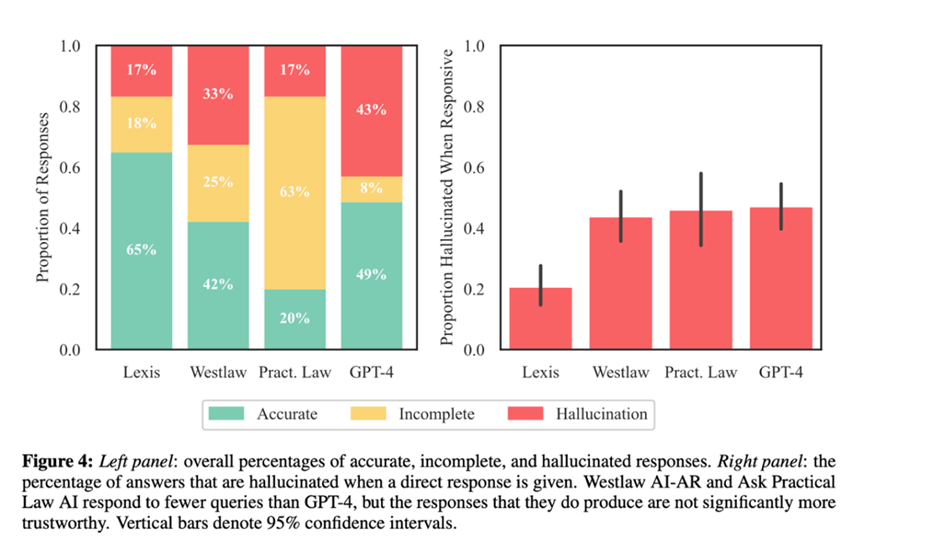

Des fournisseurs comme LexisNexis et Thomson Reuters (Westlaw) ont présenté leurs outils comme « sans hallucination ».

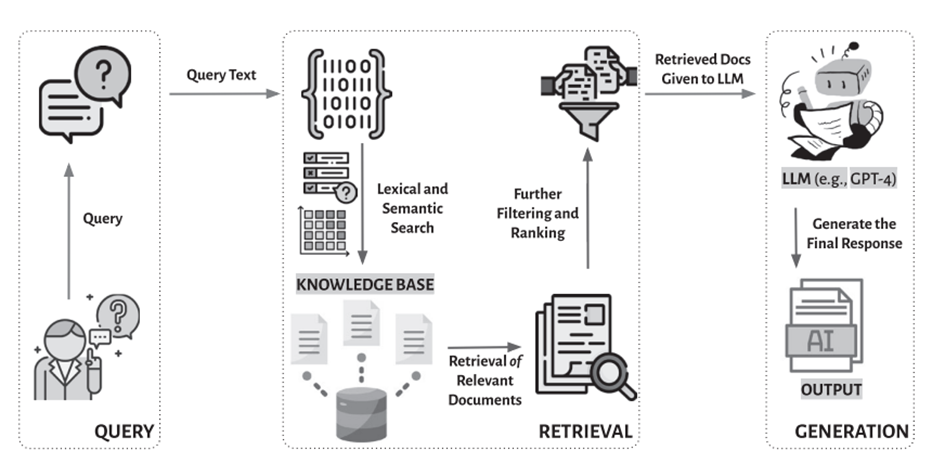

Pourtant, l’étude remet en cause ces affirmations, révélant que même les systèmes spécialisés de type RAG (Retrieval-Augmented Generation) produisent encore des hallucinations à des taux significatifs.

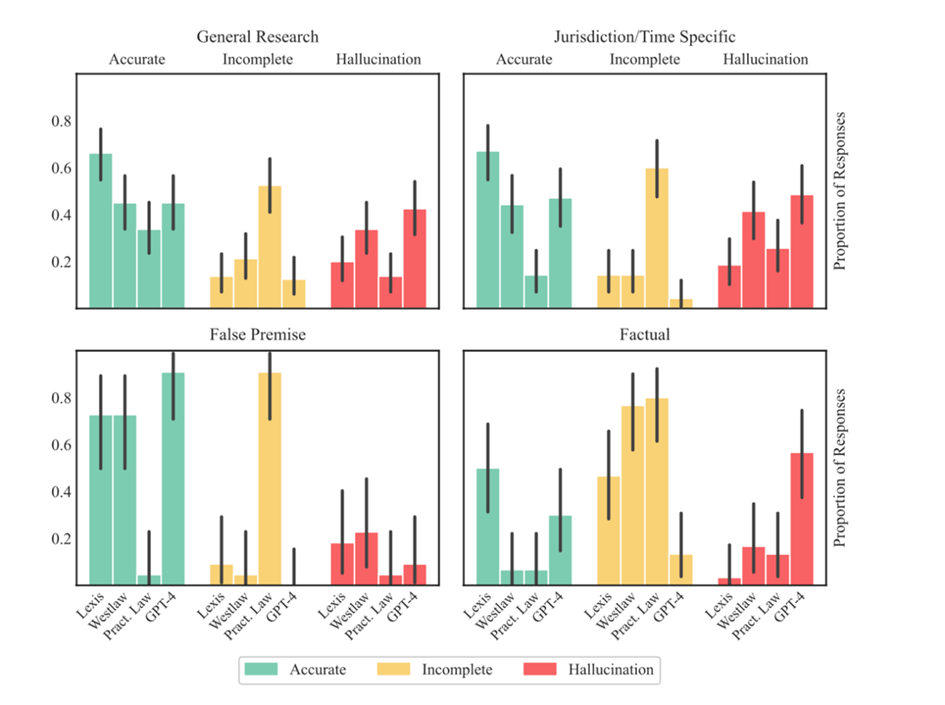

- Taux d’hallucination : entre 17 % et 33 % pour Lexis+ AI, Westlaw AI-Assisted Research et Ask Practical Law AI. C’est mieux que des chatbots généralistes comme GPT-4 (58–82 % selon les requêtes juridiques), mais ces chiffres restent préoccupants dans un domaine à forts enjeux.

- Erreurs insidieuses : l’étude élargit la notion d’hallucination aux réponses « mal ancrées » – citant de vraies sources mais inexactes, annulées ou détournées. Ces erreurs subtiles sont jugées encore plus dangereuses que l’invention pure et simple, car plus difficiles à détecter.

La charge qui pèse sur les juristes

Ces hallucinations posent un dilemme éthique et pratique majeur :

- Devoir de compétence et de supervision : les avocats sont légalement tenus de vérifier chaque sortie générée par l’IA.

- Efficacité compromise : la vérification constante annule en partie les gains de productivité annoncés, remplaçant le gain de temps par un cycle sans fin de vigilance.

- Risque de faute professionnelle : des avocats ayant cité des précédents inventés par l’IA ont déjà fait face à des accusations de négligence.

À ce stade, le droit ne peut se passer de la supervision humaine : les LLMs peuvent assister (rédiger, résumer, structurer), mais la responsabilité finale incombe toujours aux juristes.

Conclusion : les deux faces d’une même pièce

Ces deux études tracent une ligne claire dans le débat sur l’IA juridique :

- Une vision optimiste, où les LLMs sont des outils collaboratifs capables de démocratiser l’accès au droit.

- Une vision prudente, qui insiste sur les limites actuelles, notamment les hallucinations persistantes dans les outils commerciaux.

Pour que la LegalTech tienne ses promesses, plusieurs leviers sont nécessaires :

- Investir dans la transparence (publication de benchmarks de précision, reconnaissance claire des limites).

- Renforcer les safeguards (systèmes de recherche plus fiables, filtres anti-hallucination).

- Redéfinir le rôle des LLMs : outils d’assistance, pas de substitution.

- Former les juristes aux capacités et aux risques liés à l’IA.

L’avenir de l’IA juridique dépendra de cet équilibre. Les LLMs offrent un potentiel immense, mais tant que la responsabilité humaine reste incontournable – et que la transparence des systèmes commerciaux fait défaut – le rêve d’une efficacité sans effort reste hors de portée.

Comment l’industrie de la LegalTech peut-elle combler cet écart et bâtir des outils à la fois fiables et dignes de confiance ?